Die Angst vor dem stochastischen Papagei

Was erklärt den Hype um das KI-Programm Chat GPT? Sogenannte Chatbots, die beispielsweise im Kundenservice menschliche Kommunikation simulieren, gibt es schließlich schon seit Jahren. Der Unterschied ist, dass Chat GPT auf jede Anfrage reagieren kann, ohne vorgeschriebenen Programmcode. Nutzer:innen können dem Chatbot in einem Umfang Fragen stellen oder Anweisungen erteilen, der zuvor nicht möglich war. Das computergestützte System generiert daraufhin eine passende Antwort und kann so eine menschenähnliche Unterhaltung führen. Kein Wunder, dass Chat GPT damit sehr erfolgreich ist. Das Sprachmodell wurde im November vergangenen Jahres von Open AI und Microsoft als Web-App veröffentlicht, im Januar haben bereits über 100 Millionen Menschen das KI-Modell genutzt – aus Neugier, zum Programmieren oder zum Erledigen von Hausaufgaben.

Doch während manche das Programm als bloße Spielerei abtun, fürchten andere negative gesellschaftliche Konsequenzen. KI-Systeme wie Chat GPT werden viele Arbeitsgänge automatisieren und damit Arbeitsplätze vernichten, so die weitverbreitete Befürchtung. Diese Sorge ist jedoch übertrieben: Zwar mögen sich Berufe und ihre Aufgabenbereiche verändern, von KI hervorgerufene Massenarbeitslosigkeit ist aber unwahrscheinlich.

Betraf die Automatisierung in der Vergangenheit vor allem manuelle Tätigkeiten in der Industrie und Landwirtschaft, sehen sich im Falle von Chat GPT Berufsgruppen wie Graphikdesigner:innen, Übersetzer:innen, Journalist:innen und Texter:innen sowie Programmierer:innen gefährdet. Allerdings besteht in allen diesen Feldern auch die Chance, sogenannte generative Software, die automatisch neue Inhalte erzeugt, als Werkzeug in die eigene Arbeitsweise zu integrieren und so von ihren Vorteilen zu profitieren.

Die zunehmende Verfügbarkeit von KI-Anwendungen löst auch die Befürchtung aus, dass die digitalen »Intelligenzen« zu mächtig und damit unkontrollierbar werden könnten.

Der Ökonom Jens Südekum von der Universität Düsseldorf sagte er in einem Interview mit der Zeit, dass man bezüglich der Arbeitsmarkteffekte von KI noch im Nebel stochere, doch gehe er »nicht davon aus, dass es anders wird als bei disruptiven Sprüngen zuvor«. Das heißt: »Es fallen Stellen weg, dafür werden neue geschaffen.« Die bisherige Erfahrung bestätigt diese Einschätzung. Im Kapitalismus wurden immer wieder etablierte Arbeitsformen durch technischen Fortschritt überflüssig gemacht, dies führt auch immer wieder zu Arbeitslosigkeit und Prekarisierung, doch das erhoffte oder befürchtete umfassende Verschwinden der Arbeit hat sich bisher nie eingestellt.

Die zunehmende Verfügbarkeit von KI-Anwendungen löst auch die Befürchtung aus, dass die digitalen »Intelligenzen« zu mächtig und damit unkontrollierbar werden könnten.

»Sollen wir wirklich riskieren, dass wir die Kontrolle über unsere Zivilisation verlieren?« Auf keinen Fall, finden die Unterzeichner:innen eines offenen Briefs, der eine Entwicklungspause für neue KI-Modelle fordert. Wenn die KI-Entwickler:innen sich nicht selbst dazu entschließen, sollten Regierungen die Pause anordnen, so die Forderung.

Mehr als 27 000 Menschen haben den Brief inzwischen unterschrieben, darunter bekannte Persönlichkeiten wie der Twitter-Besitzer Elon Musk und der Historiker Yuval Noah Harari. Der Brief ist ein eindringliches Plädoyer, einen Moment innezuhalten, um nicht möglicherweise den Untergang der Menschheit zu riskieren. Dabei ist es noch ein langer Weg, bis KI-Systeme einen Status erreichen, der so etwas wie einem digitalen Verstand gleichkäme.

Große Künstliche Neuronale Netze

Der Nimbus von KI lässt sich leicht zerstreuen, wenn man sich die zugrundeliegende Technologie anschaut – das maschinelle Lernen. Dabei werden Algorithmen dazu trainiert, Datensätze auf bestimmte Regeln und Muster hin zu analysieren. So wurde das Sprachmodell GPT mit öffentlich zugänglichen Daten aus dem Internet trainiert. Basierend auf diesen Informationen kann es spezifische Antworten generieren, indem es die Wahrscheinlichkeit berechnet, dass auf ein bestimmtes Wort ein anderes folgt.

Auch andere KI-Systeme, etwa Bildgeneratoren wie DALL-E und Midjourney, nutzen die Methode des vielschichtigen maschinellen Lernens. Sie greifen dabei auf große Künstliche Neuronale Netze (KNN) zurück. Ein KNN ist ein Modell aus verknüpften Datenpunkten, das den Verknüpfungen von Nerven im menschlichen Gehirn ähnelt. Allerdings sind generative Computersysteme deswegen noch lange nicht intelligent, sie beruhen schließlich nach wie vor auf stochastischen Rechnungen.

Aus diesem Grund bezeichnete eine Gruppe von KI-Forscher:innen der Pennsylvania State University Sprachmodelle wie Chat GPT kürzlich in einem Forschungspapier als »stochastische Papageien«, die alles nachplapperten, was die Trainingsdaten hergeben. KI-Modelle sind nicht empfindungsfähig, haben kein Gewissen und verfolgen weder eine bestimmte Absicht noch eigene Ziele. Kurz gesagt, sie haben keinen Bezug zu einer fühlbaren, erfahrbaren und emotionalen Realität.

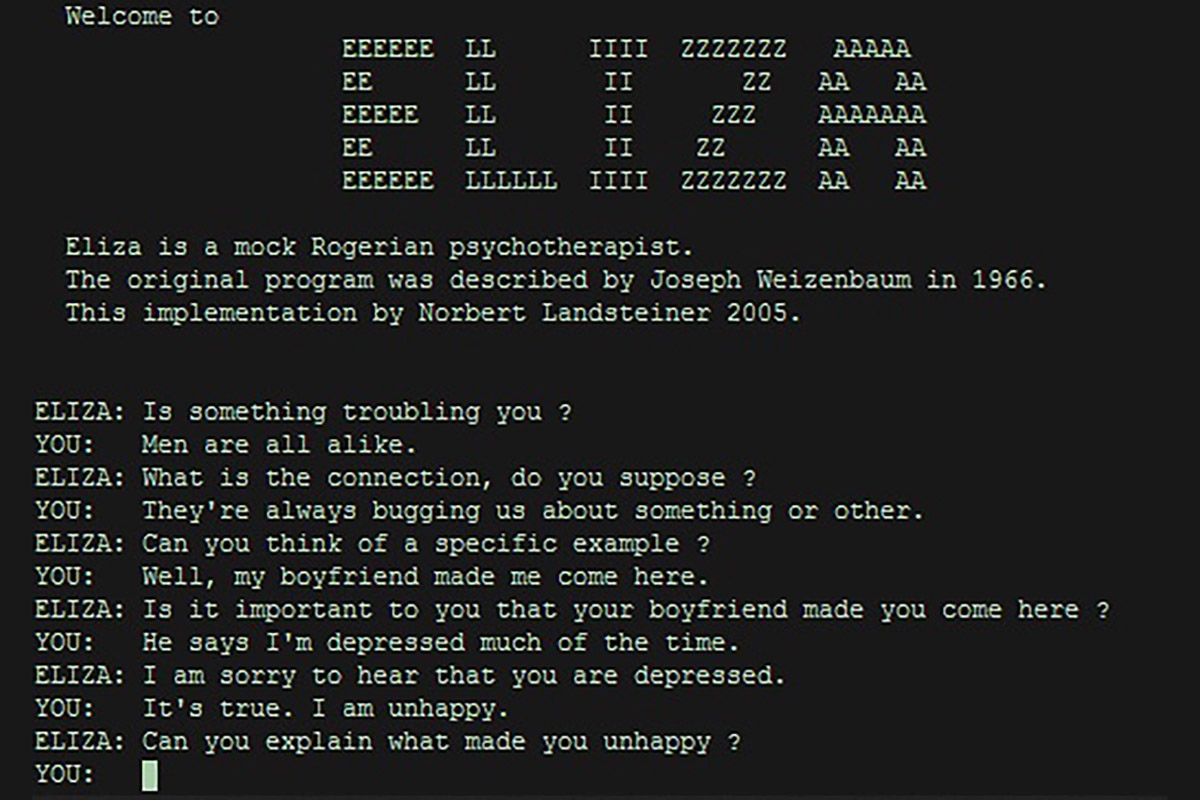

Bereits im Jahr 1966 stellte der Informatiker Joseph Weizenbaum vom Massachusetts Institute of Technology den Chatbot Eliza vor, der von den Testpersonen wie ein Mensch wahrgenommen und behandelt wurde.

Dennoch überhöhen und vermenschlichen Nutzer:innen die Technologie häufig. Diese Tendenz ist nicht neu, die Kritik daran auch nicht: Bereits im Jahr 1966 stellte der Informatiker Joseph Weizenbaum vom Massachusetts Institute of Technology den Chatbot Eliza vor, der von den Testpersonen wie ein Mensch wahrgenommen und behandelt wurde. Selbst kurzer Kontakt mit einem relativ einfachen Computerprogramm könne bei ganz normalen Menschen stark wahnhaftes Denken auslösen, schrieb Weizenbaum in seinem 1976 veröffentlichten Buch »Computer Power and Human Reason. From Judgement to Calculation« (deutscher Titel: »Die Macht der Computer und die Ohnmacht der Vernunft«, 1978), in dem er vor der Mystifizierung von Computertechnologie warnte. Sie laufe darauf hinaus, auch den Menschen auf ein computerähnliches informationsverarbeitendes System zu reduzieren.

Trainingsdaten von Chat GPT

Dieser »Eliza-Effekt« fand sich unlängst in Aussagen des damaligen Google-Entwicklers Blake Lemoine wieder, der KI Bewusstsein attestierte. Er sagte vergangenes Jahr der Washington Post, der Google-Chatbot LaMDA erinnere ihn an ein »sieben- oder achtjähriges Kind«, das sich für Physik interessiere. Nachdem Lemoine mit seiner Theorie, das Programm habe menschenähnliche Gefühle entwickelt, an die Öffentlichkeit gegangen war, wurde er von Google entlassen.

Dennoch ist nicht zu leugnen, dass die neue Generation der generativen Software Dinge leisten kann, die zuvor nicht möglich waren. Doch ihr Erfolg ist nicht technischem Hokuspokus geschuldet, sondern vielmehr der schieren Rechenleistung, die mittlerweile verfügbar ist, um riesige Datenmengen zu analysieren.

Die Trainingsdaten von Chat GPT bestehen aus verschiedenen Textquellen aus dem Internet, darunter Online-Artikel, Kundenrezensionen und Beiträge in sozialen Medien. Dem technischen Dokument zu Chat GPT zufolge können in den Daten auch persönliche Informationen enthalten sein. Das wirft Fragen des Schutzes der Privatsphäre und persönlicher Daten auf. Die italienische Datenschutzbehörde hat das bereits Ende März bemängelt, woraufhin Chat GPT sein Angebot für italienische Nutzer zeitweilig einschränkte. Chat GPT informiere Personen nicht darüber, dass Daten über sie gesammelt worden sind, und könne Falschinformationen über Personen liefern, kritisierte die italienische Aufsichtsbehörde.

Bisher sind es vor allem milliardenschwere Unternehmen, die die neuen Technologien anbieten und vermarkten. Um der Monopolstellung entgegenzuwirken, fordern Kritiker die Vergesellschaftung solcher KI-Systeme.

Über ein Verbot von Chat GPT wird auch in Deutschland diskutiert. Ein Gremium der deutschen Datenschutzaufsichtsbehörden untersucht, ob Open AI gegen die Europäische Datenschutz-Grundverordnung (DSGVO) verstößt. Die Vorsitzende des Gremiums, Marit Hansen, Datenschutzbeauftragte des Landes Schleswig-Holstein, sagt im Gespräch mit der Jungle World: »Der Chat-GPT-Anbieter Open AI hat aufgrund der bisherigen Kritik von Datenschutzbehörden bereits Änderungen zugesagt.« Nun sei abzuwarten, wie die Firma sich im Detail verhalte: »Wir gehen davon aus, dass Open AI unsere Fragen anhand des neuen Sachstands beantworten wird, so dass wir auf dieser Informationsbasis unsere Bewertung vornehmen werden.«

Doch offensichtlich können Aufsichtsbehörden bislang kaum prüfen, welche Daten KI-Systeme wie Chat GPT nutzen. Das ist problematisch, da eine Kontrollinstanz fehlt, die nachvollziehen könnte, welche Daten in die Software einfließen, von wem sie stammen und welche Motive damit möglicherweise verfolgt werden.

Grundsätze der Open-Source-Bewegung

Nach den Grundsätzen der Open-Source-Bewegung soll die Gesellschaft diese Kontrollinstanz sein: Die Datenmengen sollten öffentlich zugänglich sein, so dass alle Menschen in der Lage wären, zu überwachen und mitzuentscheiden, wie Daten verwendet und verbreitet werden – und ob dies im gesellschaftlichen Interesse geschieht. Denn sonst könnten Verzerrungen in Trainingsdaten unentdeckt bleiben. Schließlich geben »stochastische Papageien« unreflektiert das Ergebnis von Trainingsdaten wieder und können somit beispielsweise diskriminierende Ansichten einfach reproduzieren. Hinzu kommt, dass KI-Anwendungen durch ihre vielschichtigen und dadurch oft undurchsichtigen neuronalen Netze in gewisser Hinsicht eine Blackbox bleiben, solange neben den Eingabedaten nicht auch nachvollziehbar ist, wie die Programme im Einzelnen funktionieren.

Bisher sind es vor allem milliardenschwere Unternehmen, die die neuen Technologien anbieten und vermarkten. Um der Monopolstellung entgegenzuwirken, fordern Kritiker wie der Sprecher des Chaos Computer Clubs, Linus Neumann, die Vergesellschaftung solcher KI-Systeme. Auch die Journalistin Eva Wolfangel, die sich mit dem Thema Künstliche Intelligenz beschäftigt, sieht darin eine Chance. Die Gesellschaft hätte dann mehr Möglichkeiten mitzugestalten, dass KI-Systeme in Zukunft so eingesetzt werden, dass sie einen Nutzen für die Allgemeinheit bringen. Linus Neumann betont im Gespräch mit der Jungle World: »Die erhebliche Automatisierungsdividende sollte der Gesellschaft zugutekommen, und diese sollte auch eine Kontrolle über die Systeme haben.« Ansonsten, so Neumanns Prognose, werde die Technologie primär dem Kapital dienen.